Der Big Data Engineer spielt eine zentrale Rolle im modernen Datenmanagement. Seine Hauptverantwortung liegt im Design und Aufbau leistungsstarker Datenplattformen, die eine effektive Datenverarbeitung und umfassende Datenanalyse ermöglichen. Durch die Implementierung von ETL-Prozessen (Extract, Transform, Load) werden Daten aus verschiedenen Quellen integriert, um schnelle und präzise Einblicke zu gewähren. Die kontinuierliche Optimierung dieser Plattformen ist entscheidend, um Unternehmen einen Wettbewerbsvorteil zu verschaffen.

Die Rolle des Big Data Engineers in der Datenverarbeitung

Der Big Data Engineer spielt eine entscheidende Rolle in der Datenverarbeitung, um Unternehmen dabei zu unterstützen, aus ihren großen Datenmengen wertvolle Erkenntnisse zu gewinnen. Durch seine Expertise sorgt er dafür, dass Datenströme effizient verarbeitet und analysiert werden. Dies ermöglicht es den Organisationen, datengetriebene Entscheidungen zu treffen und ihre Geschäftsmodelle zu optimieren.

Was macht einen Big Data Engineer?

Ein Big Data Engineer ist für die Entwicklung und Implementierung von Datenarchitekturen zuständig. Zu seinen Hauptaufgaben gehören:

- Entwurf von Datenmodellen für effiziente Datenspeicherung

- Implementierung von Datenpipelines zur Verarbeitung großer Datenmengen

- Optimierung der Datenflüsse zwischen verschiedenen Systemen

- Zusammenarbeit mit Datenanalysten und anderen Stakeholdern

Diese Aufgaben erfordern tiefgreifendes Wissen in der Datenverarbeitung sowie fundierte Kenntnisse von verschiedenen Datenbanktechnologien und Programmiersprachen.

Fähigkeiten und Qualifikationen eines Big Data Engineers

Um in der Rolle des Big Data Engineers erfolgreich zu sein, sind bestimmte Fähigkeiten und Qualifikationen erforderlich. Zu den wichtigsten gehören:

- Beherrschung von Programmiersprachen wie Python, Scala oder Java

- Erfahrung mit Datenbankmanagementsystemen und Big Data Technologien wie Hadoop oder Spark

- Kenntnisse in der Cloud-basierte Datenverarbeitung

- Verständnis für Datenanalyse-Tools und Techniken

Zusätzlich stärken persönliche Fähigkeiten wie Problemlösungsfähigkeiten, Teamarbeit und analytisches Denken die Effektivität eines Big Data Engineers in der Datenverarbeitung.

Big Data Engineer: Aufbau leistungsstarker Datenplattformen

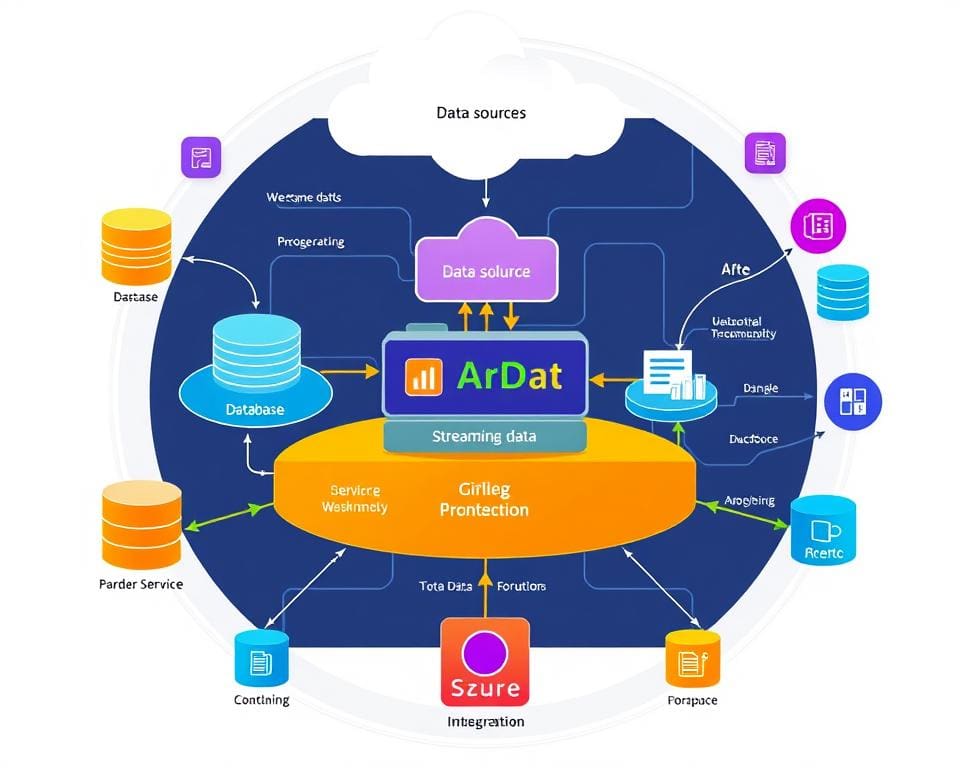

Der Aufbau leistungsstarker Datenplattformen ist eine komplexe Aufgabe, die zahlreiche essentielle Komponenten umfasst. Ein Big Data Engineer spielt dabei eine entscheidende Rolle, um sicherzustellen, dass diese Plattformen nicht nur effizient, sondern auch leistungsfähig sind. Die richtige Datenarchitektur ist unerlässlich, um die Anforderungen an die Datenverarbeitung zu erfüllen und der effektiven Datenintegration eine solide Grundlage zu bieten.

Wichtige Komponenten einer effektiven Datenplattform

Eine effektive Datenplattform benötigt eine Vielzahl von Schlüsselkomponenten. Dazu gehören:

- Robuste Datenbenutzeroberflächen, die eine intuitive Interaktion ermöglichen.

- Fähigkeit zur Verarbeitung unterschiedlicher Datenformate, sowohl strukturierte als auch unstrukturierte Daten.

- Optimierte Speicherungslösungen, um Zugriff und Analyse zu erleichtern.

- Leistungsfähige Datenverarbeitungstools zur Unterstützung komplexer Abfragen.

Die Bedeutung von Datenarchitektur

Die Datenarchitektur ist das Rückgrat jeder Datenplattform. Sie definiert, wie die Daten strukturiert und verwaltet werden. Eine durchdachte Datenarchitektur gewährleistet:

- Konsistenz und Qualität der Daten über den gesamten Prozess.

- Hohe Skalierbarkeit, um mit wachsendem Datenvolumen umgehen zu können.

- Erleichterte effektive Datenintegration, die für agiles Arbeiten notwendig ist.

Datenintegration und ETL-Prozesse im Data Engineering

In der Welt des Data Engineering spielen ETL-Prozesse eine entscheidende Rolle. Durch die effektive Datenintegration wird sichergestellt, dass Daten aus unterschiedlichen Quellen kohärent und übersichtlich verarbeitet werden. Dies ermöglicht Unternehmen, wertvolle Einblicke zu gewinnen.

Was sind ETL-Prozesse?

ETL-Prozesse, die für Extrahieren, Transformieren und Laden stehen, sind wesentliche Komponenten des Datenmanagements. Sie ermöglichen es, Daten aus verschiedenen Quellen zu extrahieren, diese in ein nutzbares Format zu transformieren und schließlich in Datenbanken oder Data Warehouses zu laden. Der gesamte Prozess fördert die Effizienz und Qualität der Daten und unterstützt die analytischen Bedürfnisse moderner Unternehmen.

Best Practices für die Datenintegration

Um die Effektivität der Datenintegration zu maximieren, sollten Unternehmen einige Best Practices beachten:

- Regelmäßige Datenbereinigung: Dies stellt sicher, dass die Integrität der Daten vor dem Laden gewahrt bleibt.

- Automatisierung der ETL-Prozesse: Automatisierte Prozesse reduzieren Fehlerquellen und beschleunigen die Datenverarbeitung.

- Überwachung der Datenflüsse: Durch das Monitoring können potenzielle Probleme frühzeitig erkannt und behoben werden.

- Flexible Datenmodelle: Anpassen der Datenmodelle ermöglicht eine effiziente Verarbeitung von neuen Datenquellen.

Datenanalyse und Datenmanagement für Unternehmen

Im digitalen Zeitalter sind Datenanalyse und Datenmanagement unverzichtbare Bestandteile für den unternehmerischen Erfolg. Ein Big Data Engineer spielt hierbei eine zentrale Rolle, indem er Unternehmen dabei unterstützt, ihre Unternehmensdaten strategisch zu nutzen. Durch die Definition wichtiger KPIs können Unternehmen fokussierte Analysestrategien entwickeln, die auf qualitativ hochwertigen Daten basieren.

Der Einsatz moderner Analysewerkzeuge ermöglicht es Unternehmen, prägnante Trends zu identifizieren und proaktiv Risiken zu minimieren. Mit den richtigen Datenanalysetools im Arsenal können Firmen nicht nur ihre operative Effizienz steigern, sondern auch fundierte Entscheidungen treffen, die das Wachstum fördern.

Darüber hinaus fördert effektives Datenmanagement die Integrität und Verfügbarkeit von Daten, was für eine präzise Datenanalyse entscheidend ist. Ein gut strukturierter Datenmanagementprozess trägt dazu bei, dass Unternehmen in der Lage sind, aktuelle Marktanforderungen schnell zu erfüllen und sich von der Konkurrenz abzuheben.